Сценарий знакомый. VPS живой, по SSH заходишь, пинг идёт, домен резолвится. Но сам туннель ведёт себя странно: то подключается через раз, то скорость падает до смешного, то приложения отваливаются, хотя «в браузере вроде открывается».

Часто это списывают на «плохой сервер» или «глючит клиент». На практике причина нередко в другом: современные сети умеют классифицировать трафик по поведению и применять к разным классам разные правила. Без «взлома», без чтения содержимого. Просто статистика, тайминги и протокольные особенности.

Ниже — инженерное объяснение, как это обычно устроено и почему шифрование само по себе не гарантирует одинаковое отношение к любому соединению. Я намеренно не разбираю методы обхода ограничений и «маскировку» — цель статьи в другом: понять механику и научиться диагностировать, что именно ломается.

Почему «шифровано» не значит «неотличимо»

Даже если внутри всё зашифровано, на сетевом уровне остаётся много метаданных. Оператор сети видит не содержимое пакетов, а «рисунок» соединения:

- как часто устанавливаются новые сессии;

- сколько живёт соединение;

- размеры пакетов и их распределение;

- соотношение входящего и исходящего трафика;

- TCP или UDP, есть ли ретрансляции, как ведут себя окна, таймауты.

Обычный веб-сёрфинг и «туннель для всего подряд» отличаются статистически. Этого часто достаточно, чтобы применить отдельные политики: где-то режут UDP, где-то занижают приоритет, где-то ставят жёсткие лимиты на долгие сессии.

DPI и классификация трафика по поведению

DPI в реальном мире — это не только «посмотреть заголовки». Часто это набор механизмов классификации. Система смотрит на признаки и решает, к какому классу отнести поток: браузер, видео, голос, обновления, туннели, «непонятно что».

Типовые признаки «туннельного» трафика, которые легко ловятся статистикой:

- очень длинные соединения без пауз;

- равномерная «пилка» трафика даже когда пользователь ничего не делает;

- нехарактерное соотношение up/down (например, постоянно много исходящего);

- сессии с одинаковыми параметрами и одинаковым паттерном повторов.

Это не «расшифровка». Это просто профиль поведения. И сети умеют на него реагировать.

TLS-отпечатки (JA3/JA4): почему клиент «палится» сам, даже на 443

Есть ещё один слой — отпечатки TLS. Когда клиент начинает TLS-сессию, он отправляет набор параметров: версии протокола, список шифров, расширения, ALPN и порядок всего этого. У популярных браузеров и библиотек эти наборы довольно характерные.

Идея простая: если снаружи это выглядит как HTTPS, но набор параметров очень «нетипичный» для массовых клиентов, поток может попасть в категорию «нестандартный». Дальше включаются политики сети: от приоритезации до более строгих таймаутов.

Это не «запрет по списку», а типичная практика сетевой аналитики. Её используют не только против туннелей: так же классифицируют ботов, сканеры, некоторые типы автоматизации.

Активные проверки: когда сеть сама «трогает» сервер

Иногда ограничения выглядят странно: у одного пользователя работает, у другого нет, потом внезапно наоборот. Одна из причин — активные проверки. Подозрительные IP/порты могут попадать в автоматику, которая периодически пробует установить соединение и смотрит, как сервис реагирует на нетипичный трафик.

Обычный веб-сервер на такие штуки отвечает предсказуемо: стандартные ошибки, закрытие соединения, нормальные тайминги. А вот специализированные сервисы иногда отвечают иначе. И это становится дополнительным сигналом для классификатора.

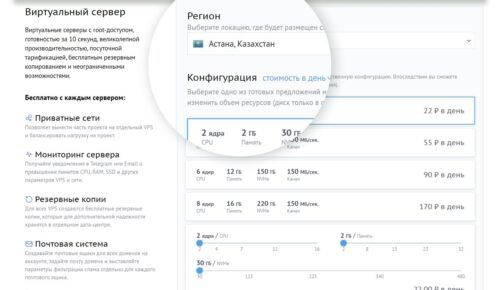

Почему «частный VPS только для меня» не гарантирует спокойную жизнь

Логика «я один, значит незаметно» работает не всегда. Сети смотрят не на число пользователей, а на профиль потока. Если один IP постоянно отдаёт «туннельный» рисунок, этого хватает, чтобы применить к нему отдельные правила. Даже если с него никто больше не ходит.

Плюс есть бытовая вещь: многие VPS-пулы (особенно дешёвые) уже «с историей». IP мог раньше использоваться под что угодно, и репутационный след иногда тянется дольше, чем хочется.

Как выглядит «ограничение» в реальности

Чаще всего это не прямой «запрет», а деградация. Поэтому и ощущение такое: «вроде работает, но криво».

- ограничение скорости до низкого приоритета;

- сбросы долгих соединений (RST, таймауты);

- ухудшение UDP (потери, джиттер, короткие окна);

- фильтрация отдельных портов или типов потоков;

- странные проблемы с установлением сессии при высокой нагрузке.

Из-за этого обычные сайты могут открываться нормально, а конкретные приложения (звонки, стриминг, синхронизация) рассыпаются.

Что делать по-инженерному: диагностика стабильности, а не «магия»

Когда туннель ведёт себя нестабильно, важно отделить сетевые проблемы от проблем сервера и клиента. Вот минимальный набор проверок, который даёт ясную картину.

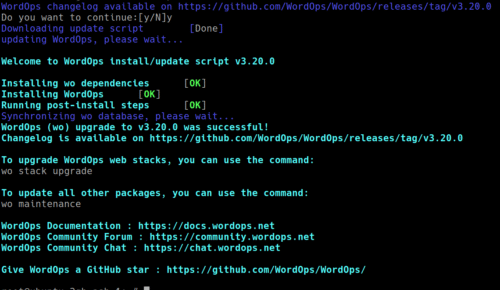

1) Проверь маршрут и потери

ping -c 20 ВАШ_IP_ИЛИ_ДОМЕН mtr -rw ВАШ_IP_ИЛИ_ДОМЕН

Если уже на этом этапе есть потери/скачки задержки, дальше любой протокол будет страдать. Тут вопрос не к «конфигу», а к линии/маршруту.

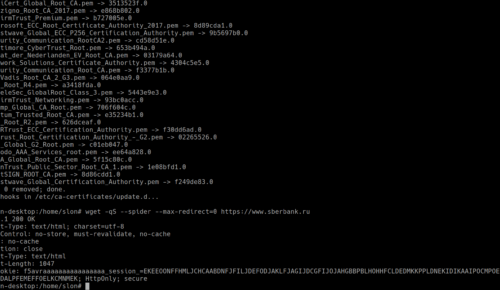

2) Посмотри, не упираешься ли в MTU

Туннели часто чувствительны к MTU. Особенно если где-то по пути есть PPPoE, мобильные сегменты или сложный маршрут. Симптомы: соединение «есть», но часть сайтов/сервисов висит, крупные ответы не проходят, SSL может рваться.

ping -M do -s 1472 -c 5 ВАШ_IP_ИЛИ_ДОМЕН ping -M do -s 1464 -c 5 ВАШ_IP_ИЛИ_ДОМЕН ping -M do -s 1452 -c 5 ВАШ_IP_ИЛИ_ДОМЕН

Если большие пакеты не проходят, придётся корректно настроить MTU/MSS на стороне клиента/сервера. Это обычная сеть, без шаманства.

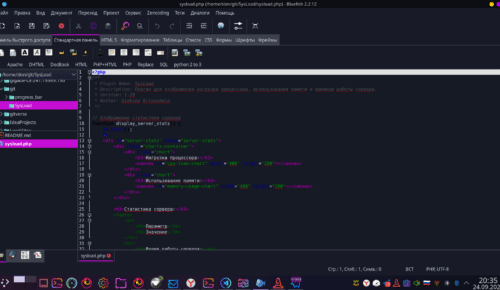

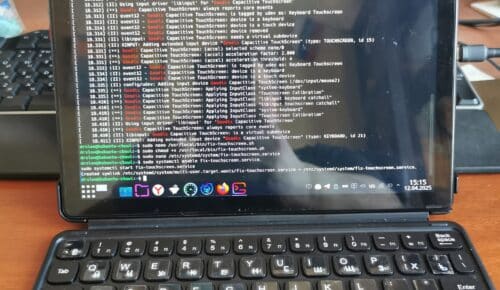

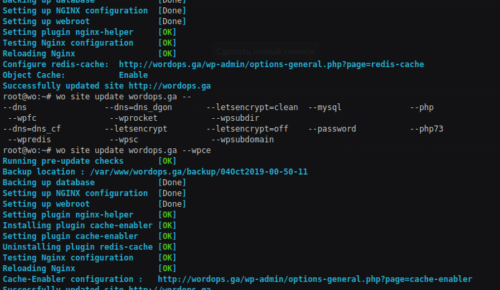

3) Сними симптомы в логах сервера

uptime free -h vmstat 1 5 ulimit -n ss -s journalctl -xe --no-pager | tail -n 200

Если сервер упирается в лимиты, «нестабильность сети» будет выглядеть как сетевые сбои, хотя причина банально в ресурсах.

Честный вывод

Современные сети давно научились отличать классы трафика по поведению. Это не «взлом шифрования», а аналитика и управление качеством. Из-за этого частные туннели в некоторых сегментах могут работать нестабильно даже при исправном сервере.

Самый здравый подход — понимать, где ломается цепочка (маршрут, MTU, ресурсы сервера, особенности UDP/TCP), и править именно это. А если упираешься в сетевые политики, которые от тебя не зависят, важно хотя бы увидеть это в диагностике и не тратить сутки на «переписать конфиг 20 раз».